Aujourd'hui, le mot de "cloud" est dans toutes les bouches dans tous les domaines : on proposera au photographe d'envoyer ses photos dans le "cloud", aux étudiants de travailler de manière collaborative grâce au "cloud", aux professionnels d'embrasser ces nouvelles technologies qui permettront des gains d'efficacité et même nos politiques saisissent la tendance et promettent de faire de la France un meneur dans le domaine...

Il y a pourtant d'irréductibles libristes qui prônent l'auto-hébergement et le rejet des plateformes privatrices et avancent pour cela de nombreux arguments (qui me semblent pertinents, vous vous en doutiez) et posent de nombreuses questions.

Revenons ici sur l'une de ces questions : quelle est l'acceptabilité d'une solution "cloud" hébergée par des acteurs non connus, dans des infrastructures informatiques distantes et non localisées ?

Un acteur raisonnable jugera "acceptable" toute technologie dont le bénéfice dépasse le risque et qui apporte un gain d'utilité (par ex. une meilleure efficacité, une meilleure sécurité). Le même acteur refuserait une technologie si le gain (par ex. gain de temps) risque de devenir négatif avec une forte probabilité. C'est finalement l'espérance du gain qui doit être prise en compte pour accepter ou non la nouvelle technologie.

Je prétends que l'espérance de gain est négative avec les solutions "cloud" sur lesquelles aucun contrôle n'est possible.

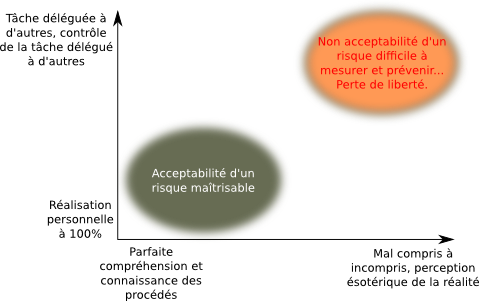

Pour représenter l'acceptabilité, traçons deux axes :

- en abscisse, le degré de connaissance technique, compréhension d'une technologie

- en ordonnée, le degré de délégation pour la mise en place de la technologie

On peut découper cet espace en 4 zones :

- En bas à gauche, nous avons les technologies connues, comprises et réalisées complètement sans délégation à un tiers. C'est la situation optimale car le risque est alors évalué et les mesures appropriées peuvent être prises pour le réduire.

- En haut à gauche, ce sont les technologies que l'on maîtrise parfaitement et que l'on délègue toutefois à un tiers. La parfaite connaissance permet toutefois de s'assurer de la bonne réalisation par le tiers et cela reste encore acceptable.

- En bas à droite, la technologie n'est pas du tout comprise mais elle est déployée localement. Le niveau de risque est important mais il est assumé localement. Un effort de formation permettra de revenir vers le quadrant "en bas à gauche". Ou alors il sera décidé de sous-traiter, et on arrive alors dans le dernier quadrant...

- En haut à droite, la technologie n'est pas comprise et elle est déléguée à un tiers. Tout contrôle est alors illusoire et seule la confiance dans le tiers permet au système de tenir. C'est la situation la plus inacceptable puisque jugement et liberté disparaissent, le tiers devient tout-puissant dans le système.

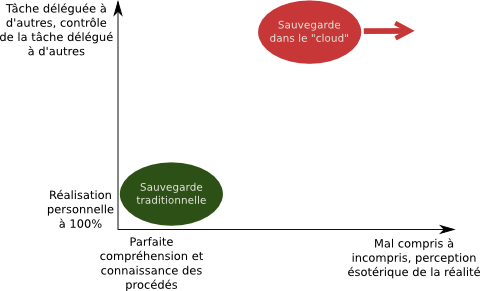

A mes yeux, la sauvegarde classique ("à l'ancienne" avec par exemple un disque dur externe chez soi, ou alors en déployant un NAS local) appartient au quadrant le plus favorable (en bas à gauche). Les solutions de type "cloud" appartiennent de plus en plus au quadrant le plus défavorable "en haut à droite". En effet, pour simplifier la vie de l'utilisateur, on ne lui donne aucun détail technique et on lui propose des interfaces simplifiées, fonctionnelles seulement au travers de clients (certes bien léchés) non extensibles et pas parfaitement intégrables. Nous sommes alors dans la situation la plus inacceptable car la plus risquée et privatrice de liberté.

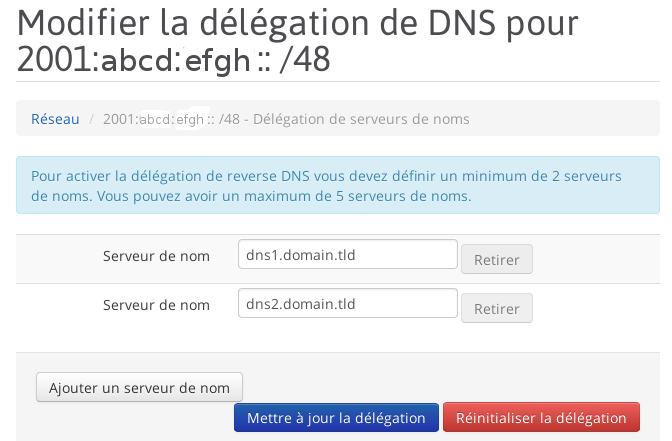

Il y a toutefois des offres un peu plus responsables : Hubic d'OVH par exemple... A minima, l'utilisateur saura où ses données sont stockées (localisation géographique des datacenters), il connaît la technologie sous-jacente (OpenStack Swift) et une API (qui espérons-le va encore se développer) permet un certain niveau de contrôle. Ce n'est pas suffisant mais c'est un bon début !

Il est indispensable, me semble-t-il, d'éduquer les utilisateurs sur les risques d'un "cloud" non maîtrisé (pertes de données sans recours, aucune garantie autre que celle du marketing sur le soin prêté aux données, accès aux données par des tiers, erreurs inattendues...).

Stocker ses données dans des infrastructures dédiées et protégées est une très bonne démarche, mais elle ne doit absolument pas se faire en perdant de vue la compréhension des mécanismes en place, en renonçant à leur contrôle et en "offrant les clés de sa vie" à des tiers à qui l'on ne peut faire que moyennement confiance !